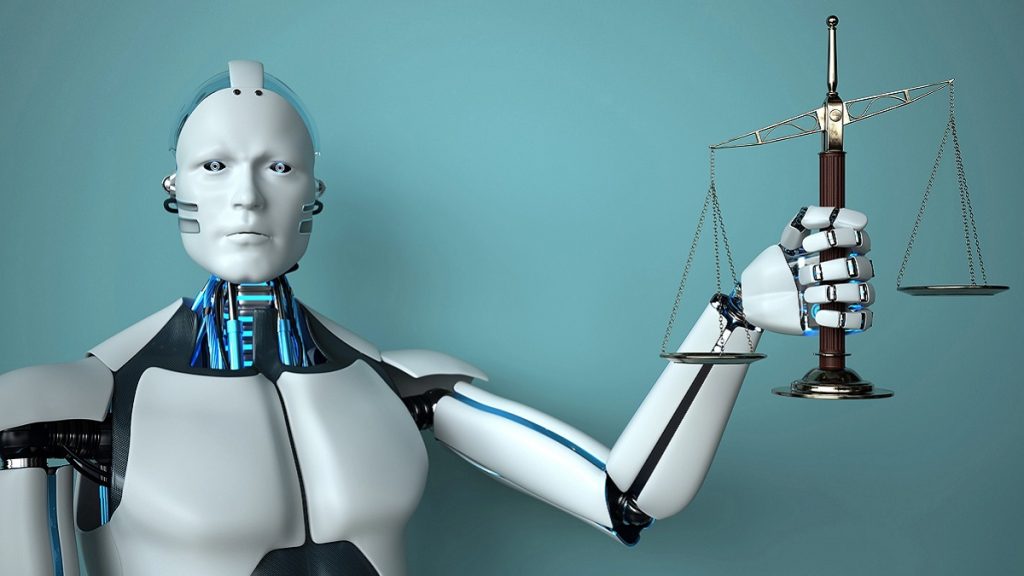

هوش مصنوعی شروع به ایجاد پروندههای قانونی اما جعلی کرده و راه خود را به دادگاههای واقعی باز میکند. این موضوع نه تنها مسائل قانونی و اخلاقی را زیر پا میگذارد، بلکه تهدیدی برای تضعیف ایمان و اعتماد به سیستمهای حقوقی جهانی است.

دادگاهها باید در مورد اختلافات بر اساس قانون که توسط وکلا به عنوان بخشی از پرونده موکل به دادگاه ارائه میشود، تصمیم گیری کنند. بنابراین بسیار نگران کننده است که قانون جعلی که توسط هوش مصنوعی ابداع شد، در اختلافات حقوقی مورد استفاده قرار گیرد.

قوانین جعلی چگونه به وجود میآیند؟

شکی وجود ندارد که هوش مصنوعی مولد ابزاری قدرتمند با پتانسیل تحول آفرین برای جامعه، از جمله بسیاری از جنبههای سیستم حقوقی است. اما استفاده از آن با مسئولیتها و خطراتی همراه است! وکلا برای به کارگیری دقیق دانش و تجربه حرفهای آموزش دیدهاند و عموماً ریسک پذیر نیستند. با این حال، برخی از وکلای بی احتیاط، گرفتار هوش مصنوعی شدهاند. مدلهای هوش مصنوعی بر روی مجموعه دادههای عظیم آموزش داده میشوند. محتوای تولید شده با هوش مصنوعی ممکن است بسیار قانع کننده به نظر برسد، اما میتواند نادرست باشد.

این نتیجه تلاش مدل هوش مصنوعی برای «پر کردن شکافها» زمانی است که دادههای آموزشی آن ناکافی یا ناقص است. اگر هوش مصنوعی محتوای نادرست ایجاد کند که سپس در فرآیندهای قانونی استفاده شود، این یک مشکل بزرگ است.

نمونههایی از جعل مدارک در دادگاه توسط وکلا

این امر میتواند منجر به بی دقتی در تحقیقات حقوقی و تهیه اسناد شود و به طور بالقوه مشکلاتی برای حرفه وکالت و عدم اعتماد عمومی به اجرای عدالت ایجاد کند. شناختهشدهترین «پرونده جعلی» مولد هوش مصنوعی، پرونده ماتا علیه آویانکا در ایالات متحده در سال 2023 است. در این پرونده، وکلا خلاصهای از اسناد و مدارک جعلی از پرونده را به دادگاه نیویورک ارسال کردند. این خلاصه با استفاده از ChatGPT مورد بررسی قرار گرفت. وکلا، غافل از اینکه ChatGPT می تواند توهم ایجاد کند، نتوانستند بررسی کنند که این موارد واقعاً وجود داشته است. عواقب آن فاجعه بار بود. پس از کشف این خطا، دادگاه پرونده موکل خود را رد کرد. همچنین وکلای خود را به دلیل سوء نیت تحریم کرد و شرکتشان را جریمه کرد.

علاوه بر این نمونههای جعلی دیگر همچنان در حال ظاهر شدن هستند. مایکل کوهن، وکیل سابق دونالد ترامپ، پروندههای وکالت خود را که توسط Google Bard، یک ربات چت مولد هوش مصنوعی دیگر تولید شده بود، ارائه کرد. او معتقد بود که آنها واقعی هستند، اما واقعی نبودند.

با استفاده نادرست وکلا از هوش مصنوعی، چگونه باید مقابله کرد؟

در این رابطه در سرتاسر جهان، قانونگذاران حقوقی و دادگاهها به روشهای مختلف واکنش نشان دادند. چندین دادگاه ایالتی، نظرات یا دستوراتی در مورد استفاده مولد از هوش مصنوعی صادر کردند. از پذیرش مسئولانه گرفته تا ممنوعیت کامل این فناوری! انجمنهای حقوقی در بریتانیا و بریتیش کلمبیا و دادگاههای نیوزلند نیز دستورالعملهایی را تدوین کردند. در استرالیا، انجمن وکلای NSW یک راهنمای هوش مصنوعی برای وکلای دادگستری دارد. انجمن حقوقی NSW و موسسه حقوقی ویکتوریا مقالاتی را در مورد استفاده مسئولانه مطابق با قوانین رفتار وکلا منتشر کردند.

بسیاری از وکلا و قضات، مانند عموم مردم، درک درستی از هوش مصنوعی مولد دارند و میتوانند محدودیتها و مزایای آن را تشخیص دهند. اما افراد دیگری هم هستند که ممکن است آنقدر آگاه نباشند. وکلایی که از ابزارهای هوش مصنوعی مولد استفاده میکنند نمیتوانند آن را جایگزینی برای قضاوت و سخت کوشی خود بدانند و باید صحت و قابلیت اطمینان اطلاعاتی را که دریافت میکنند بررسی کنند.

حال با این شرایط اگر این روند کنترل نشود، چگونه میتوانیم اطمینان حاصل کنیم که استفاده از هوش مصنوعی مولد اعتماد عمومی را به سیستم قانونی تضعیف نمیکند؟ کوتاهی مداوم وکلا در استفاده از این ابزارها میتواند باعث گمراهی و شلوغی دادگاهها شود. همچنین ممکن است به منافع موکلان آسیب برساند و به طور کلی حاکمیت قانون را تضعیف کند. تعیین الزامات روشن برای استفاده مسئولانه و اخلاقی از هوش مصنوعی مولد، موجب پذیرش مناسب و افزایش اعتماد عمومی به وکلا را در بر دارد. در نتیجه باید تدابیری برای آن اندیشیده شود.

اخبار روز: آمریکا مقابل bot fram روسیه میایستد