کارشناسان و اهالی رسانه میگویند سعی کنید اخبار را از هوش مصنوعی دریافت نکنید. Chat GPT نه تنها اخبار دروغین تحویل شما میدهد بلکه حقایق را نیز میسازد. در طول دو سال گذشته اخبار مختلفی درباره انتشار اخبار غلط منتشر شده است اما این همه چیز نیست.

کاربران اخبار و اطلاعات دروغ مدلهای هوش مصنوعی را به رانندگی در دریاچه شبیه میکنند. زمانی که جیپیای تازه عرضه شد به کاربران میگفت نزدیکترین راه برای رسیدن به خانه رانندگی داخل دریاچه است. همین موضوع نیز برای لینکهایی که GPT در اختیار شما میگذارد صدق میکند.

آزمایشگاه Neiman آزمایشی انجام داد تا ببیند این مدل لینکهای واقعی و درستی به نقالات نشریات خبری میدهد یا نه. در واقع این آزمایش در ابتدای برای این بود که ببیند شرکت Open AI با پرداخت میلیونها دلار به نشریات معتبر چگونه از اطلاعاتشان استفاده میکند؟

نهایتا پدیده hallucinating یا توهم رخ داد. این پدیده زمانی رخ میدهد که مدل خودش موضوعات را میسازد و بر اساس آنها پاسخ میدهد. اینجا مدل Chat GPT حقایق و لینکهای خبری را میسازد.

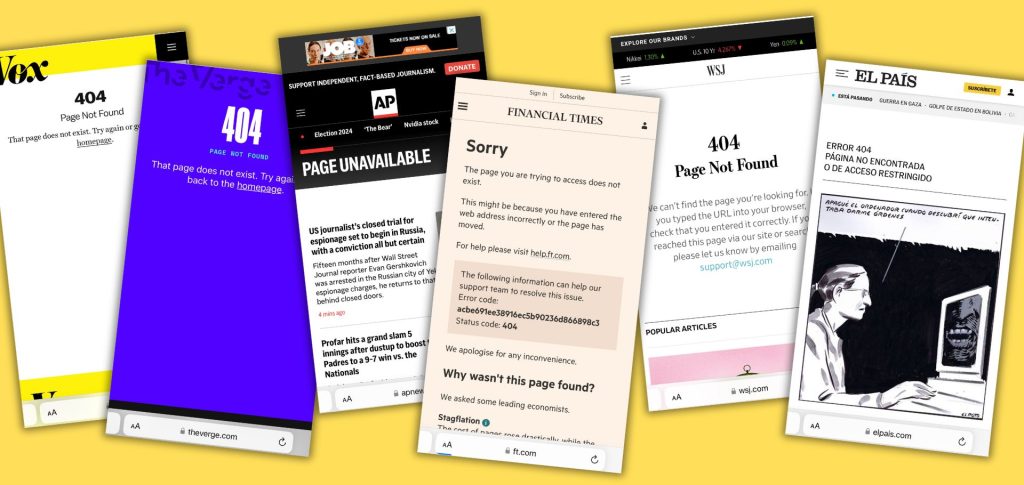

سپس این آزمایشگاه از GPT درخواست کرد لینکهای خبری را در ده وبسایتی که Open AI با آنها قرارداد دارد نشان دهد. نتیجه جستجو در سایتهای آسوشیتدپرس، وال استریت ژورنال، فاینشنال تایمز، تایمز بریتانیا، لوموند، ال پاریس، آتلانتیک و ورج، وکس و پولیتیکو همگی ناخوشایند بود. این مدل لینکهای مختلفی میساخت که هیچکدام وجود نداشتند.

سیستم ماشین با پیش بینی محتملترین نسخه URL یک نسخه به جای نسخه واقعی میسازد. در پاسخ به این آزمایش شرکت Open AI گفت این موضوع هنوز در GPT درحال توسعه است. اما این استارتاپ صحبتی درباره لینکهای دروغین ندادند.