همین چند وقت پیش خبری جنجالی از مایکروسافت و Open AI منتشر شد. این دو شرکت از منابع آب ایالات آریزونا برای خنک کردن سرورهای خود استفاده میکنند. آریزونا با بحران آب رو به رو است. از منابع آب آن برای بخش عظیمی از تاسیسات خود استفاده میکند. همین موضوع هم نگرانیهای زیادی در پی داشته است.

حالا مایکروسافت یک مدل زبانی جدید ارائه کرده است. مدل 1-bit! اساس این مدل چیست؟ خب تا الان با رشد مدلهای زبانی بزرگ، میزان حافظه این مدلها هم رشد بیشتری کرده است. مدلهای حال حاضر معمولا 16 بیتی، 13 بیتی یا 70 بیتی هستند که مشکلات زیادی پیش میآورند. هدف جدید شرکتها و استارتاپها هم پیشروی به سمت کاهش حجم و رسیدن به مدلهای مشابه اما با حجم 4 بیتی است.

حالا مایکروسافت از مدل 1 بیتی خود رونمایی کرده است. این مدل قرار است مشکلات مدلهای 16 بیتی را نداشته باشد. البته پس از رونمایی از این مدل، مدل 1.58Bits هم ارائه شد. طبق ادعای مایکروسافت، هر دوی این مدلها مشابه یک مدل 16 بیتی داده دارند؛ اما با حجم کمتر!

این مدل BitNet b1.58 چه مزیتی دارد؟

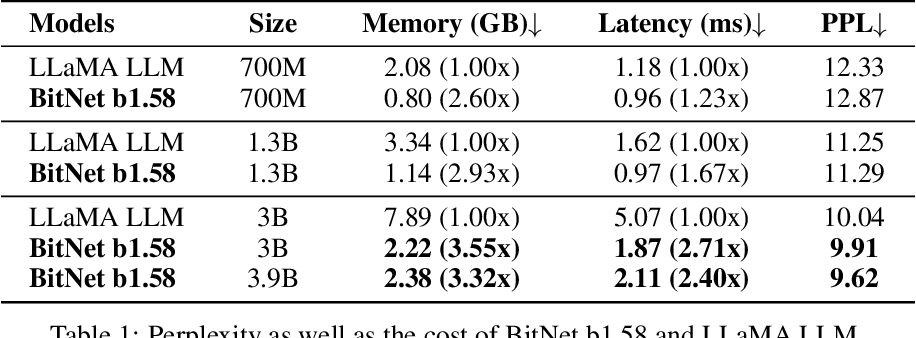

اولین مزیت این مدل کم حجم بودنش است. یک مدل با 70B داده، از مدل مشابه LLAM 70B تقریبا 4 برابر سریعتر است! دلیلش هم این است که هر چه اندازه مدل بزرگتر میشود میزان پردازش و زمان پردازش طولانیتر میشود.

مورد دوم، گفتیم بحران آب، در همین مثال بالا این مدل نسبت به مدل مشابهاش یعنی لاما تقریبا 72 برابر انرژی کمتری برای محاسبات خود مصرف میکند.

مورد بعدی با کم حجم شدن این مدلها کار برای توسعه دهندهها و موبایلها هم راحتتر است. با این مدل دیگر نیازی چندانی به سخت افزارهای فوق سنگین و حرفهای نیست و افراد بیشتری میتوانند از این مدلها استفاده کنند.

در آخر هم توسعه و استفاده از این مدلها باعث میشود میزان آب و انرژی که برای خنک کردن سرورها و تاسیسات نیاز است کمتر شود. همین موضوع به حفظ آب و محیط زیست کمک زیادی خواهد کرد. خصوصا الان که با بحرانهای زیست محیطی زیادی رو به رو هستیم.