مدل جدید شرکت Open AI یعنی GPT-4o منتشر شد. این مدل قرار است تعامل طبیعیتری با انسان داشته باشد. یکی از ویژگیهای مهمی که این شرکت روی آن تاکید میکند نوع اطلاعات ورودی و خروجی آن است.

این مدل میتواند صدا، متن و تصویر یا ترکیبی از آنها را به عنوان ورودی بگیرد و با هر ترکیبی یک خروجی ارائه دهد. به ورودیهای صوتی با میانگین 320 میلی ثانیه و در کمتر از 232 میلی ثانیه پاسخ میدهد. این سرعت عمل دقیقا مشابه انسان است.

شرکت Open AI در ماههای گذشته اعلام کرده بود احتمال دارد مدل بعدیای که منتشر میکند Chat GPT-5 باشد اما این مدل عرضه شد.

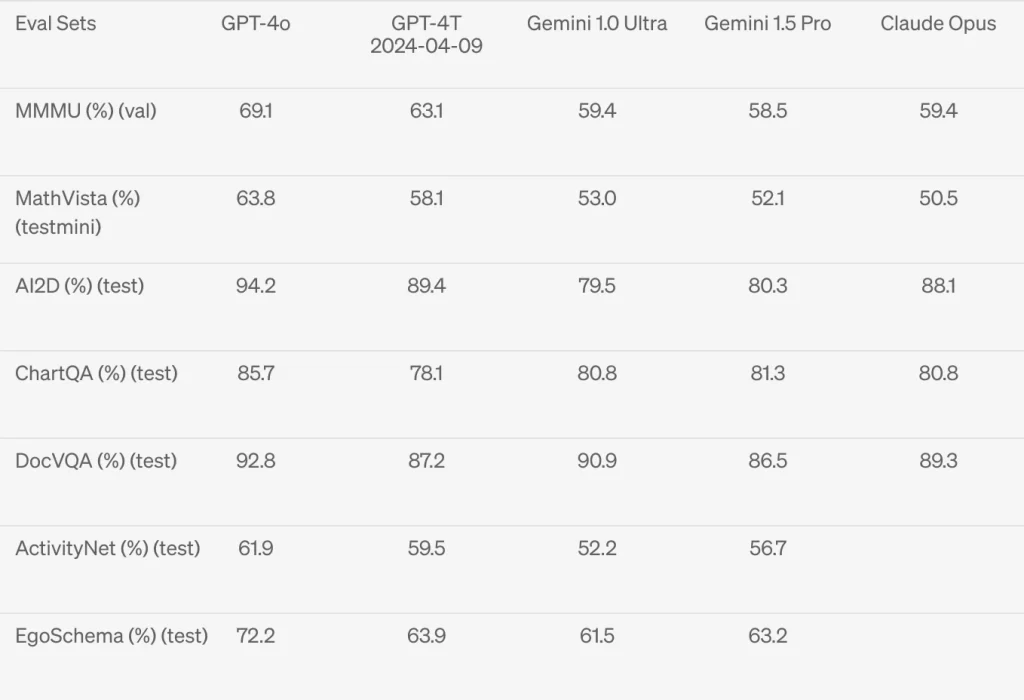

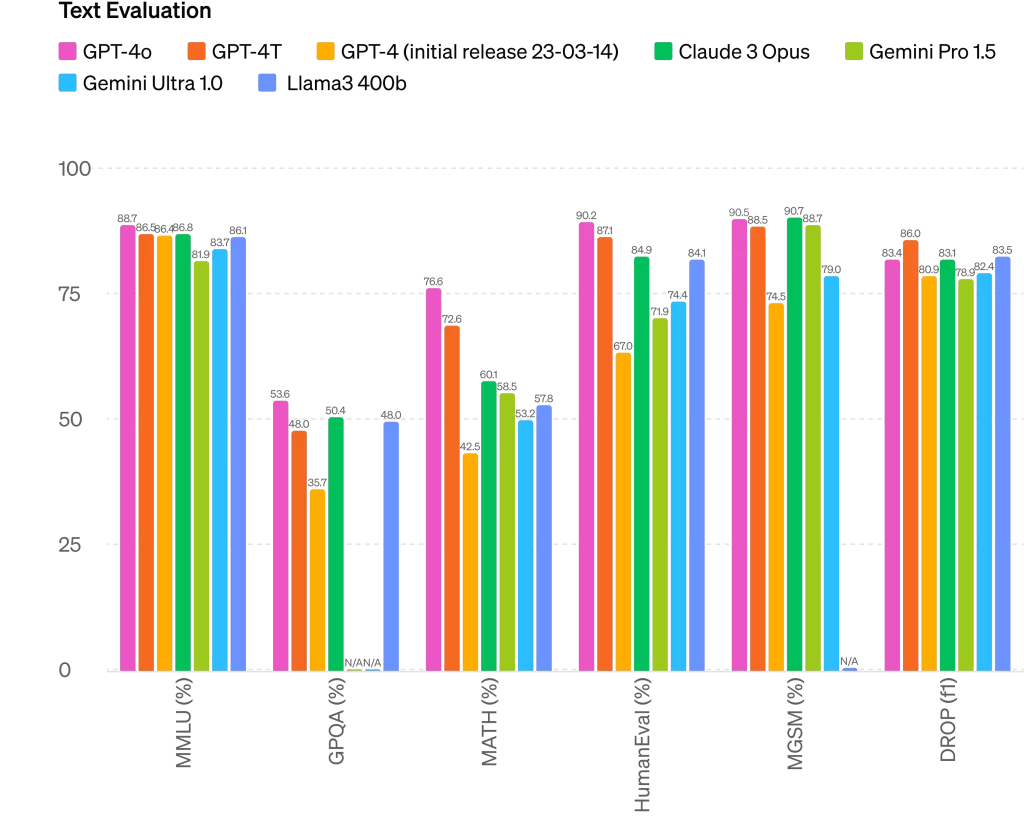

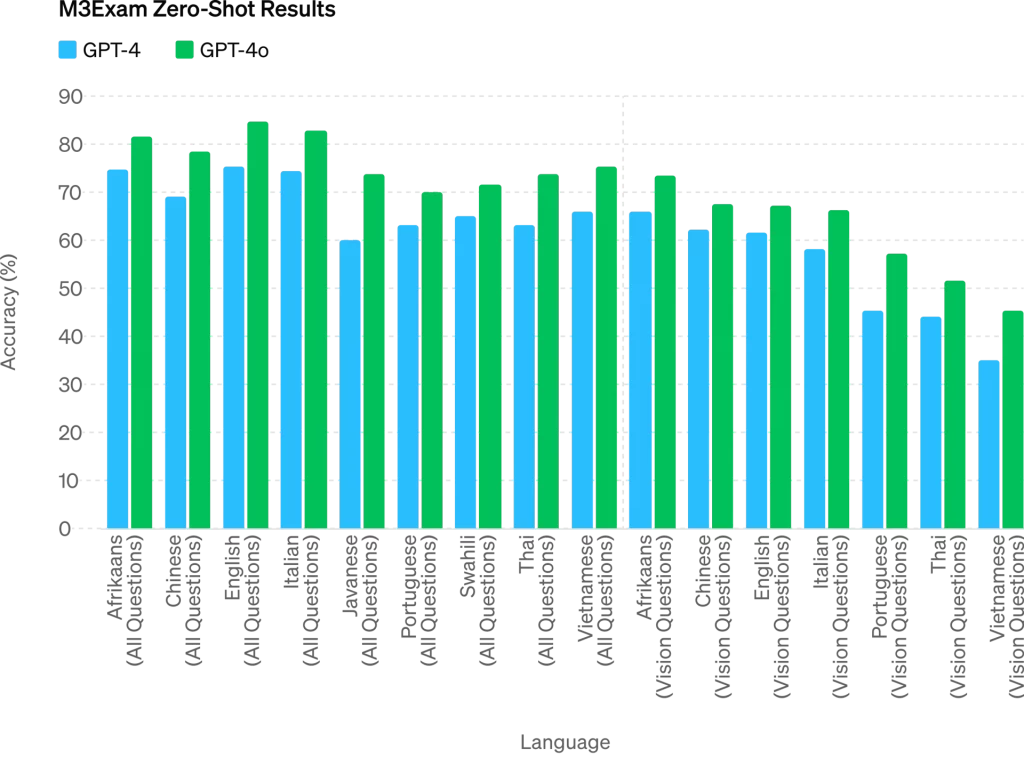

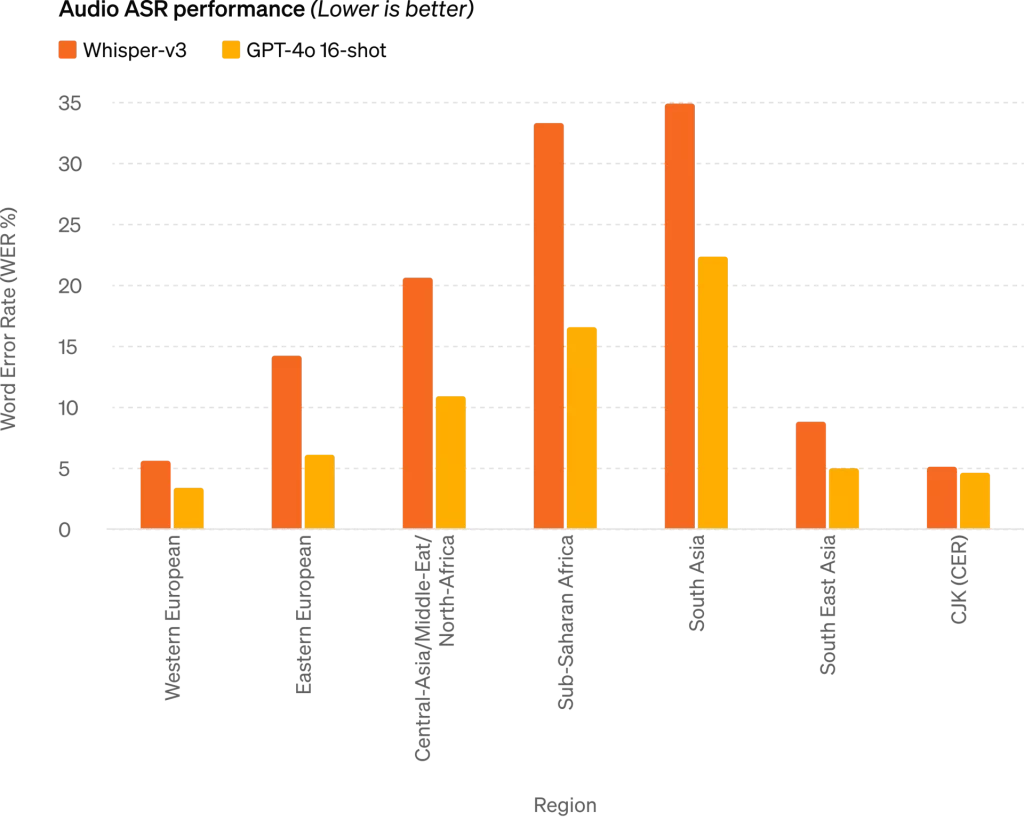

مدل GPT-4o نسبت به مدل GPT-4 turbo روی متون غیر انگلیسی بسیار بهتر کار میکند. هزینه API آن هم نسبت به مدل قبلی بسیار بهتر و سریعتر است. این مدل در درک بصری و صوتی نسبت به مدلهای مشابه و مدلهای جدید بسیار توانایی بالاتری دارد.

قبل از این مدل، مدلهای پیشین در سه مرحله یک صدا را تحلیل میکردند. این مراحل باعث میشد مدل نتواند احساسات، شوخیها و … را درک کند و در نتیجه نمیتوانست آن را به کاربر بازگرداند.

دسترسی به این مدل به چه شکل خواهد بود؟

قابلیتهای متنی و تصویری GPT-4o از امروز در ChatGPT ارائه شده است. در آینده این مدل رایگان و پرمیوم برای کاربران پلاس با حداکثر 5 برابر محدودیت بیشتر در دسترس خواهد بود. . مرحله اول این مدل برای تیم قرمز و بعضی از شرکای این شرکت در دسترس قرار میگیرد. در هفتههای آینده این مدل در ChatGPT Plus به صورت عمومی عرضه خواهد شد.

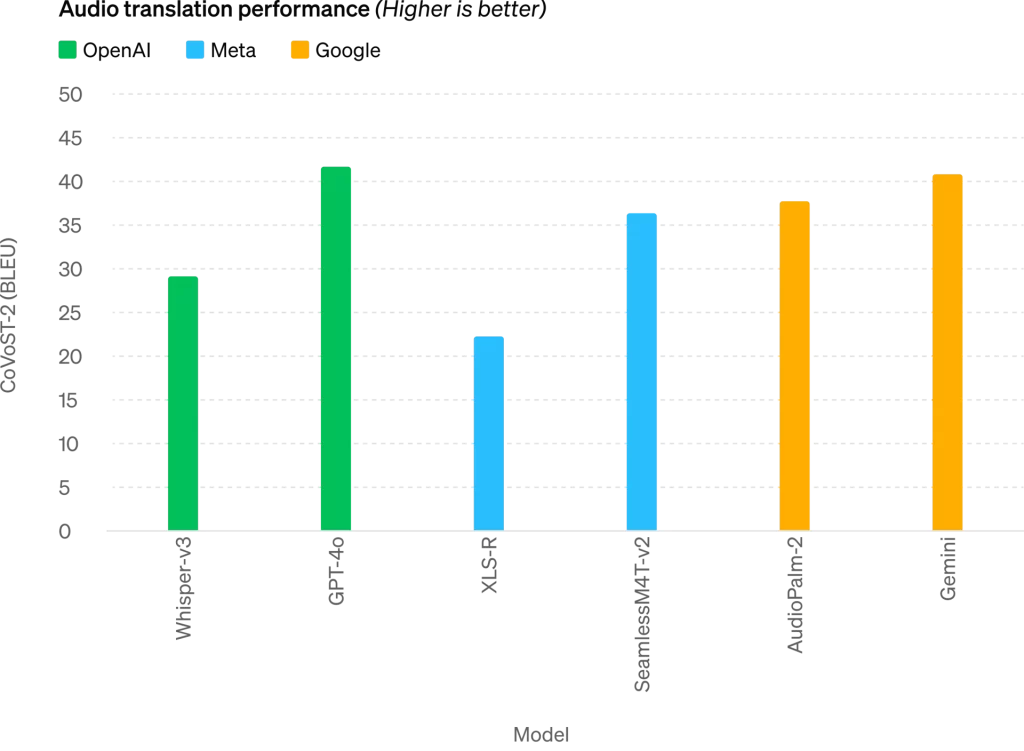

نتایج بنچمارکهای این مدل نسبت به دیگر مدلها عملکرد بهتری را نشان میدهد.

این مدل با استفاده از شبکه عصبی تمام ورودیها را پردازش میکند. نوع ورودی آن ترکیبی است و به نوعی در بین مدلها جدید به حساب میآید. این شرکت هنوز اول کار این مدل است و باید دید در عمل چه عملکردی خواهد داشت.